L’imagerie numérique

Le monde de la photographie a été totalement bouleversé (au même titre que la vidéo et les télécommunications) avec l’avénement du numérique.

Le numérique offre de nombreux avantages sur sa grand-soeur, l’imagerie argentique. Les avantages ne sont pas négligeables : Mémorisation sur carte mémoire permettant l’obtention quasi-immédiate des images ; plus besoin de s’isoler dans un labo tout noir pour développer les négatifs et tirer les épreuves ; traitement des images directement sur l’ordinateur sans avoir à numériser le négatif ou la diapositive d’origine (ce qui demande un travail beaucoup plus rigoureux puisqu’il faut calibrer le scanner avec précision pour une gestion correcte des couleurs – Numérisation argentique).

La surface sensible chargée de mémoriser une image était jusque-là composée de grains de nitrate d’argent. Depuis, cette surface a été remplacée par un capteur électronique de caractéristiques figées, composé de photodiodes (pixels) qui réagissent aux photons comme les grains de la bonne vieille pellicule en transformant la lumière sous la forme d’un signal. Alors que dans le cadre d’une pellicule, c’est une réaction chimique qui va permettre l’obtention de l’image (développement) ; Dans le cadre du capteur CCD/CMOS, l’image est reconstituée directement par des signaux électroniques binaires (0 ou 1) et ces signaux sont stockés sous la forme d’un fichier image sur la carte mémoire. Complémentairement à l’utilisation d’un capteur CCD/CMOS conduisant à tous ces progrès, l’appareil photo moderne numérique tend également à se rapprocher de plus en plus de l’ordinateur en embarquant un processeur toujours plus puissant jouant un rôle majeur dans l’optimisation des capacités du boitier notamment dans les hautes sensibilités ISO mais également dans l’opérationnalité d’une véritable stabilisation optique.

En finalité, l’ordinateur occupe désormais une place tout juste optionnelle pour assurer un traitement spécifique des images et leur stockage à long terme.

L’imagerie numérique : La triangulation entre deux hardwares et un software

J’appelle communément « imagerie numérique », l’imagerie courante découlant de l’utilisation d’un appareil photo numérique (compact ou reflex) pour faire des photos ou faire de la photo (la différence est subtile mais bien réelle, à qui saura saisir la différence). L’imagerie numérique actuelle se situe au carrefour d’une triangulation de trois éléments (dont le choix judicieux de chacun de ceux-ci définira les performances de l’appareil) :

- Le choix d’un système ou de la combinaison de plusieurs systèmes mécaniques

- Le choix d’un type de capteur numérique

- Le choix d’une partie logicielle constituée par l’élément déterminant qu’est le processeur

Du temps de l’imagerie argentique (sur pellicule), l’appareil photo était presque 100% mécanique et chimique puisque le simple passage d’une vue à une autre découlait d’un entraînement physique d’un film photosensible. La question du choix du capteur numérique par le constructeur ne se posait pas car tout dépendait entièrement du choix de la pellicule par l’utilisateur (sensibilité, qualité de l’émulsion, dominance colorifique, négatif ou diapositive ?) ; quant au processeur, tout au plus servait t-il uniquement dans les tous derniers reflex argentiques modernes commercialisés jusqu’au milieu des années 2000 à faire fonctionner les systèmes de mesure d’exposition, l’autofocus, l’entraînement du film et à décompter le nombre de vues restantes sur une pellicule donnée. Au delà des quelques similitudes cités plus haut, plus rien n’est pareil, tout a changé car avec le remplacement de la pellicule par un capteur numérique, la fonction même du processeur s’est considérablement étoffée pour remplir dorénavant de très nombreux autres usages.

Enfin, la partie mécanique d’un compact ou d’un reflex étant les seuls éléments communs entre l’argentique et le numérique, je ne tarderai pas à préciser que le système mécanique est un hardware dont l’étude est à exclure car elle n’apporterai rien de fondamentalement nouveau pour comprendre l’imagerie numérique.

Le système mécanique : Le hardware le plus semblable à l’argentique à exclure de l’étude

Le système mécanique représente la seule vraie similitude entre argentique et numérique. Elle se décline en ces points :

- Le fait de cadrer dans un viseur à travers un objectif démontable (à nuancer toutefois avec le cadrage via un écran LCD apparu avec les appareils photo numériques compacts dont l’objectif n’est pas démontage)

- L’autofocus (à nuancer toutefois avec l’autofocus à mesure de contraste d’image apparus avec les appareils photo numériques compacts)

- L’existence d’une chambre avec le basculement d’un miroir dans le cas d’un reflex

- L’apparition d’une stabilisation optique qui arrivera beaucoup plus tard, en même temps que la technologie numérique.

En tout état de cause, afin de se concentrer exclusivement sur l’imagerie numérique, je suis ravi de pouvoir m’appuyer sur tous les exposés précédemment rédigés les années passées de façon à me faire l’économie de devoir aborder ici les parties mécaniques d’un appareil photo pour plutôt vous orienter vers une observation attentive du duo véritable faisant du numérique une révolution à part entière dans la photographie :

- Un hardware représenté par un capteur (et par le ou les lecteurs de cartes mémoire)

- Un software représenté par la partie logicielle du boitier photo (processeur)

Débarrassé de tous ces critères mécaniques intrinsèques assez similaires à l’argentique, l’appareil photo numérique n’est ni plus, ni moins qu’un ordinateur portatif spécifiquement conçu pour produire des images constitué d’un hardware (partie matérielle) et d’un software (partie logicielle). Comme dans la composition d’un ordinateur, le choix du hardware (lecteur/graveur de disque optique, vitesse/capacité du disque dur, périphériques (USB, FireWire,…), mémoire vidéo/RAM, etc…) et du software (Windows, Linux, MacOS, ChromeOS, Android,…), auront un impact direct (sinon décisif) sur les performances finales générales de l’ensemble.

Pour la composition d’un appareil photo, nous nous situons dans une similitude intéressante dans le sens où le choix du capteur numérique (pour le hardware) et le choix du processeur/logiciel interne à l’appareil (pour le software) déterminent à eux-seuls au moins 80% des performances totales de l’appareil. Les 20% restants correspondent aux seuls choix mécaniques de l’utilisateur dans le cas d’un reflex à objectifs interchangeables, notamment dans le choix de l’objectif car selon s’il est pourvu d’un stabilisateur optique ou non, les performances de l’appareil peuvent s’en trouver grandement améliorées. La qualité optique de l’objectif joue également un rôle non négligeable sur le résultat « comestique » de l’image mais là, nous nous éloignons du but affirmé de mon exposé.

Le capteur numérique : Le hardware fondamental du numérique

Le capteur est l’âme d’un appareil photo numérique car sans lui la production d’une image est impossible ; il en constitue le composant de base. Il s’agit d’un composant électronique photosensible servant à convertir un rayonnement lumineux (UV, visible ou IR) en un signal électrique. Il représente à lui seul un caractère révolutionnaire dans la photographie car il est nettement plus efficace que la pellicule d’où son utilisation première historique en astrophotographie tout d’abord par les professionnels et puis plus tard par les amateurs fortunés : Le numérique ne souffre d’aucun effet de réciprocité (phénomène de perte progressive de performance dans l’enregistrement d’une source lumineuse au fur et à mesure que le temps de pose s’allonge auquel nous étions habitués avec la pellicule). La CCD permettra à un petit club de mordus de saisir au statut d’amateur dès le début des années 80 des objets du ciel profond excessivement faibles, jusque-là inaccessibles en argentique dans leurs instruments de dimensions modestes.

De nombreux types de capteurs numériques existent sur le marché et le choix d’un capteur par un constructeur d’appareils photo varie fortement en fonction de critères technologiques ainsi que économiques retenus pour un produit donné. Néanmoins, à quelques exceptions près, le fonctionnement d’un capteur numérique est globalement le même pour tout type confondu.

Le capteur numérique est constitué d’un maillage de photosites pour les CCD et de photodiodes pour les CMOS dont la taille mais également le nombre est variable ainsi que conséquent à son format. Il transforme les photons lumineux en paires par effet photoélectrique dans le substat semi-conducteur. Il collecte alors les électrons maintenu à chaque photosite ou photodiode, tout en sachant que leur nombre est proportionnel à l’intensité de la source lumineuse capturée. L’exposition achevée, les charges sont transférées de photosite en photosite (ou de photodiodes en photodiodes) comme une chenille par le jeu de variations de potentiel cycliques appliquées aux grilles (bandes conductrices horizontales, isolées entre elles par une couche de SiO2) jusqu’au registre série horizontal. Parvenues au registre série horizontal, les charges sont converties en tensions (proportionnelles au nombre d’électrons – donc proportionnelles à l’intensité de la source lumineuse capturée) et transférées dans la capacité d’une diode « flottante ». Cette diode a pour fonction de piéger les tensions afin d’extérioriser le signal du capteur de manière à ce que celui-ci puisse ensuite faire l’objet de nouvelles transformations via un processeur et des solutions logicielles propres intégrées à l’appareil photo, en perpétuelle évolution d’une génération à une autre (Software de l’appareil – Le processeur en tête).

En partant de la schématisation d’un capteur CCD « Full Trame » trouvable sur WIKIPEDIA, j’ai réalisé l’illustration ci-dessous représentant le principe grandement simplifié du fonctionnement général d’un dispositif numérique (caméra CCD reliée à un ordinateur ou bien un appareil photographique et son processeur d’image intégré). Selon le type de software (pilotes et logiciels sur ordinateur ou processeur d’image) le stockage de l’image est effectué sur un disque dur ou bien sur une carte mémoire (SD ou CF selon le boitier employé).

Un capteur numérique : Au moins huit critères pour le définir complètement et cinq principaux à retenir pour le grand public

Il existe énormément de capteurs numériques différents pour la simple et bonne raison qu’on distingue au minimum huit critères dans la définition totale de toutes les subtilités technologiques d’une surface sensible comme celle-ci :

- La nature du capteur (CCD, CMOS, BSI CMOS, FOVEON…)

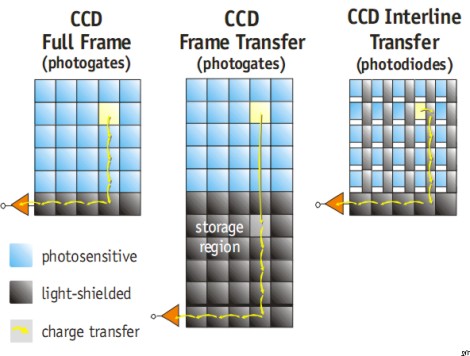

- Le fonctionnement concernant exclusivement les CCD (« Full Frame », « Full-Frame Transfer », « Interligne »)

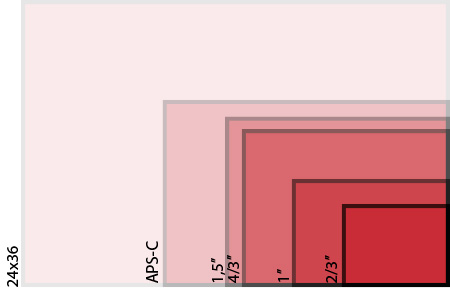

- Le format du capteur pouvant varier très fortement (de 1/4″ au format 24×36 – Tout du moins pour le grand public)

- La nature des pixels du capteur : Photosites ou photodiodes ?

- Le nombre de photosites ou de photodiodes du capteur

- La taille des photosites ou photodiodes du capteur

- Forme et agencement des photosites ou photodiodes

- Présence ou pas d’un filtre passe-bas devant le capteur

Kodak produit d’excellents capteurs CCD monochromes pour l’astrophotographie que l’on retrouve très majoritairement dans les fameuses caméras SBIG ou bien dans les excellents boitiers reflex moyen format LEICA (des appareils à part !). De tous les constructeurs de capteurs, SONY (l’initiateur du capteur CMOS) détient la palme car au moins 90% des appareils photo fonctionnent sur la base de l’un de leurs capteurs tels que ceux conçus par les deux grandes marques reines de la photo (NIKON et CANON). FUJI représente le constructeur minoritaire, qui pourtant, est à l’origine de la conception de capteurs aux caractéristiques très intéressantes les rendant notamment plus performants que les capteurs numériques classiques dans des conditions où les plages de luminosité composant une image sont très hétérogènes (des zones à la fois sous-exposées et sur-exposées) car capables de couvrir nativement la fenêtre d’une plage dynamique sensiblement plus large. De ce fait, certains boitiers FUJI ont été de véritables succès commerciaux pour le simple et unique argument pour leurs clients, d’être équipés d’un capteur numérique au fonctionnement avantageusement particulier.

Le capteur FOVEON utilisé par SIGMA représente également un modèle très particulier.

Je me limiterai à un contenu assez digeste pour la plupart de mes visiteurs en me concentrant sur les 5 critères principaux qui signent un capteur numérique :

a) La nature de ce capteur

On rencontrera dans l’imagerie numérique au moins trois grands types de capteurs : Le CCD, le CMOS et le BSI CMOS.

Le CCD est le type historique de capteur numérique. Il est composé de photosites. D’ailleurs, quand on parle communément d' »imagerie numérique », il est courant d’employer l’écart de langage « imagerie CCD » car pendant un certain nombre d’années, le CCD était le seul et unique type de capteur existant pour obtenir des images numériques que ce soit dans les scanners ou dans les appareils photo. De son nom complet Charge Coupled Device, il est le plus simple à fabriquer et possède une bonne sensibilité. Il est le fruit d’une invention ancienne remontant à 1969 du duo Georges E.Smith et William Boyle (invention qui attendra 40 ans (2009) pour être auréolée d’un Prix Nobel de physique). Il fut rapidement adopté pour les applications de pointe. Trois types de CCD (Full Frame, Full-Frame Transfer et Interligne) se sont succédé en fonction des époques et coexistent toujours en fonction de leur usage.

A retenir sur les CCD : Qu’est-ce le « blooming » ?

Phénomène surtout observable en usage astronomique avec un CCD sur des sources ponctuelles très lumineuses sur fond noir parvenant facilement à une saturation (éblouissement) affectant les pixels voisins uniquement dans le sens vertical lorsque le temps de pose est particulièrement long. Un capteur CCD est toujours favorisé en astronomie pour sa haute sensibilité, même si le CMOS est naturellement doté d’un anti-blooming par une obturation électronique.

On observait majoritairement surtout ce phénomène sur les premières caméras CCD dans les années 80. Le blooming se produit à la lecture du CCD. Pour l’éviter, on dote les caméras CCD astronomiques d’un obturateur mécanique que l’on actionne au moment de la lecture du CCD, évitant ainsi à la lumière collectée de déborder sur toute la rangée verticale de pixels. Il m’apparaissait important de marquer une petite parenthèse sur ce phénomène car il explique historiquement en partie pourquoi l’imagerie numérique aura eu du mal à trouver sa crédibilité au tout début de son existence et ceci malgré son principal avantage s’exprimant par son absence du « phénomène de réciprocité » dit « Effet Schwarzschild » (chute importante de sensibilité au fur et à mesure de l’étalement du temps de pose) comme avec la surface sensible chimique de la pellicule. |

Le CMOS est le second type de capteur numérique. De son nom complet Complementarity metal-oxide-semiconductor, il est très proche du CCD et présente pour principale caractéristique d’être très majoritairement utilisé mais également de fonctionner sous le principe d’un maillage de photodiodes et non de photosites. Quand vous achetez un appareil photo, compact ou reflex, la probabilité est très forte qu’il soit doté d’un capteur CMOS, ce qui est déjà moins évident dans les fabrications antérieures à l’année 2006 puisque pour exemple, mon premier reflex numérique (le NIKON D70) fonctionnait sous le principe d’un capteur CCD et non d’un CMOS qui équipera ensuite ses successeurs produits par la même marque. La préférence des constructeurs d’appareils photo pour ce grand type de capteur numérique s’explique par sa consommation électrique considérablement minorée, sa vitesse de lecture majorée et son très faible coût de fabrication en directe comparaison aux CCD. Avec un CMOS, on peut optimiser l’autonomie d’un appareil photo ainsi que sa réactivité à la prise de vue ; ainsi, avec des batteries de capacité équivalente, un appareil photo permet de prendre davantage d’images en une charge unique.

Le BSI CMOS est le troisième type de capteur numérique et très certainement le plus récent. De son nom complet Back Sensor Illuminated Complementarity metal-oxide-semiconductor, il s’agit d’un CMOS rétro-éclairé et cela s’exprime notamment par un bruit numérique bien contenu aux forts ISO.

b) Son format très variable en fonction des applications

Source : Absolut-Photo

Source : Absolut-Photo

Selon les appareils photo numériques utilisés (entrée de gamme, moyenne gamme ou haut de gamme), la taille de la surface sensible numérique (soit la taille du capteur) varie très sensiblement. Pour la CCD astronomique, grâce à la technique du compositage d’un grand nombre d’images et l’absence de problématique de la profondeur de champ tout comme de la dynamique, la taille du capteur peut être très petite (1/4″, 1/3″ ou 1/2″). En photographie, en revanche, dynamique et profondeur de champ deviennent des notions très importantes ; les quatre plus gros capteurs (35mm, APS, 4/3″ et 1″) sont alors la norme.

La dynamique entre zones claires et zones sombres ainsi que la profondeur de champ sont d’autant plus larges que le capteur est gros. Ce point est essentiel quand on fait notamment du paysage. En effet dans ce cas de figure bien précis, la différence de luminance entre les zones claires (le ciel) et les zones sombres (la végétation par exemple) peut piéger facilement un petit capteur présentant une mauvaise dynamique. C’est ainsi qu’il convient de privilégier autant que possible le format APS comme le minimum pour se lancer très sérieusement dans la photographie.

c) Nombre/taille de ses photosites ou photodiodes – Folie ou sagesse ?

Le nombre de photodiodes ou pixels est en augmentation continue depuis le début de l’histoire de l’imagerie numérique grand public. Si au début des années 2000 jusqu’en 2011, cette progression de la résolution pouvait très aisément s’argumenter par le soucis avec le numérique de rivaliser voire de supplanter légèrement le potentiel d’une émulsion argentique, elle me semble être devenue au-delà de cette période d’ordre exclusivement commerciale, surtout pour le commun des photographes amateurs afin d’entretenir la compétition entre acteurs. Malheureusement, compte-tenu que la taille de capteur la plus répandue chez l’amateur demeure l’APS (25 mm x 16 mm), cette croissance du nombre de pixels (donc de photodiodes) est en conséquence directe avec leur taille inversement proportionnelle (de plus en plus petites !). Or, cela n’est pas sans conséquence immédiate car faut-il le rappeler que la photographie, c’est surtout et avant tout la captation d’un signal lumineux (écriture avec la lumière directe ou incidente) ; la taille des photodiodes sera donc d’autant plus petite que la captation lumineuse sera en baisse et le signal utile revu à la baisse par rapport au bruit de lecture du capteur.

Enfin, cela peut sembler tout à fait évident mais l’autre impact de la croissance de la résolution en millions de pixels toujours plus nombreux, c’est la majoration très nette du poids des images. Ainsi, en 2005, quand j’ai débuté la photographie numérique avec le NIKON D70 à 6 millions de pixels, un RAW pesait un peu moins de 6 Mo. 10 ans plus tard, avec le FUJIFILM X100T, un RAW de 16 millions de pixels pèse un petit peu plus de 30 Mo ; et, c’est sans compter la croissance du poids des TIFF 8 bits découlant de leur développement. En plus de poser la seule question de baisse de sensibilité du capteur, la hausse continuelle de la résolution pose à terme un problème de stockage et d’archivage des oeuvres produites car dans la même logique, quand une année de photographie représentait moins de 15 Go en 2005, elle représente en 2015 plus de 100 Go soit une majoration du poids des images de facteur 10. Avec la majoration des capteurs vers les résolutions de 24 millions depuis quelques années et leur banalisation depuis 2015 sur les boîtiers amateurs les plus récents, le stockage n’ira pas en s’améliorant d’autant que des résolutions aussi élevées sont disproportionnées pour l’amateur lambda.

Il me semble personnellement que le bon dosage pour un capteur APS pour un amateur est la résolution maximum de 16 millions de pixels, tant en contraintes de sensibilité que de stockage. Hélas, depuis début 2016, même FUJI s’est résolu à évoluer vers 24 millions de pixels ce qui laisse peu d’espoir à la sagesse, à moins que ce soit en complicité avec les fabricants de disques durs dont le volume atteint désormais les 3 To (3000 Go) en fin 2015.

d) La forme et agencement de ses photosites ou photodiodes

Le capteur photographique dans une grande majorité des cas, qu’il s’agisse de CCD ou de CMOS, est formé d’alignements d’éléments appelés « photosites ». Les colonnes et rangées de ces photosites composent la « matrice » du capteur, ils réagissent à la lumière qu’ils reçoivent et la transforment en charge électrique, sur le principe d’une cellule photo-électrique. Le capteur photosensible est recouvert d’une mosaïque affectant chaque photosite à une couleur précise parmi les trois primaires utilisées (Rouge, Vert et Bleu) ; ceci à raison de deux Vert pour un Bleu ou un Rouge soit 50 % des photosites reconnaissant le vert, les deux autres couleurs se partageant 25 % respectivement afin de respecter la vision humaine pratiquement deux fois plus sensible au vert pour tenter de reproduire la réalité colorifique perçue par l’oeil humain. Aujourd’hui, la photographie numérique, au delà de la nature fondamentale du capteur dont celle du CMOS s’est très largement imposée comme un standard, elle se résume avant tout sur le marché par un choix pour le consommateur entre trois matrices couleur RVB différentes :

- Matrice de Bayer de SONY

- Matrice X-Trans de FUJIFILM

- Matrice FOVEON de SIGMA

Chacune de ses trois matrices se distinguent par un agencement spécifique de photosites/photodiodes et de leurs filtres de couleur visant à l’obtention immédiate d’une image polychromatique. Ces matrices possèdent chacune leurs qualités et leurs inconvénients.

Matrice de Bayer de SONY

Le nom vient de son inventeur, Bryce E. Bayer, de la société Eastman Kodak. La matrice traditionnelle de Bayer est la matrice couleur la plus répandue. Les deux grands, CANON et NIKON, équipent leurs appareils de capteurs SONY se réclamant de cette matrice de filtres de couleur placée entre une lentille et un capteur photographique numérique afin de pouvoir enregistrer des photographies en couleur. De ce fait, la matrice de Bayer se retrouve à 85% dans l’imagerie numérique. Du coup, les deux autres matrices font preuve d’exceptions très intéressantes comme la matrice X-TRANS de FUJIFILM.

Matrice X-TRANS de FUJIFILM

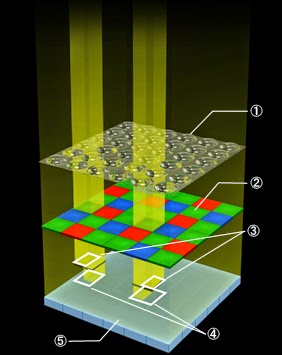

Tout d’abord, la légende se rattachant aux chiffres des repères de l’illustration à gauche permet de nommer les différents composants du capteur X-TRANS CMOS :

1-Micro-lentilles

2-La structure des filtres de couleur X-Trans (différente de la matrice de Bayer)

3-Filtre d’interception de la lumière

4-Capteur de détection de phase placé dans l’axe d’un pixel vert

5-Photodiodes

Le capteur X-TRANS CMOS se distingue par sa structure spécifique de disposition des filtres de couleur (repère.2), différente de la matrice de Bayer. De ce fait, il n’est plus nécessaire d’installer un filtre passe-bas pour combattre le moiré et la résolution atteinte dans les images se retrouve très supérieure. Avec cette matrice, FUJIFILM a été capable de développer un détecteur numérique permettant de disposer au format APS-C d’une qualité d’image surpassant même celle des appareils photo reflex full frame. Parallélement, le point très fort de cette matrice X-TRANS est son excellente dynamique, ses teintes progressives, ses dégradés riches et les 14 bits de sortie que l’on doit à sa combinaison au processeur de traitement d’image.

En travaillant en mode monochrome, j’ai été par ailleurs tout à fait ravi par la beauté des noirs et blancs et je n’ai pas été surpris après coup, après étude de la structure fonctionnelle du capteur, d’y découvrir un ratio favorable aux pixels blancs et verts. L’analyse de l’organisation des pixels selon le brevet N°2013-258168 de FUJIFILM laisse apparaître cette disposition exotique semblant favorable très probablement à la prise de vue en noir et blanc par des blancs plus profonds, les pixels blancs permettant au passage très judicieusement d’assurer un gain en sensibilité par rapport à la structure de Bayer qui n’en possède pas !

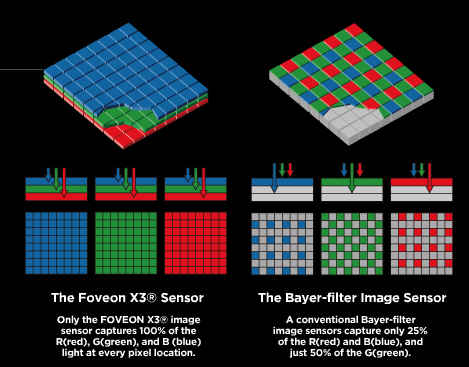

Matrice FOVEON de SIGMA

La matrice FOVEON est la plus originale.

L’illustration ci-contre permet la comparaison immédiate entre la matrice FOVEON de SIGMA et la fameuse matrice de Bayer promue par SONY. Plus globalement, comparativement aux deux matrices précédentes (BAYER et X-TRANS) restituant une image calculée, reconstituée à partir d’informations partielles correspondant au tiers de l’information totale de l’image réelle (chaque pixel ne voyant qu’une couleur), la matrice FOVEON de SIGMA enregistre quant à elle, pour chaque pixel, les trois couleurs qui composent la lumière : le bleu, le vert et le rouge. L’image capturée par les boîtiers SIGMA est donc une image vue intégralement en couleurs par le capteur.

En théorie, le capteur FOVEON a une résolution trois fois supérieure par un vrai triplet RVB, mais la pratique est toute autre car la construction en profondeur de la matrice et son principe de soustraction pour déterminer la couleur conduit à deux très marquants inconvénients :

- Tendance à être faussé par les rayons obliques (optiques grand-champ)

- Niveau du bruit de fond plus élevé qu’une autre matrice

e) Le filtre passe-bas éventuellement installé sur le capteur

Depuis 2013, le filtre passe-bas semble peu à peu disparaître des capteurs numériques équipant les plus récents boîtiers alors que c’était pourtant la norme dans tous les appareils photo numériques. Le filtre passe-bas optique, parfois appelé « filtre anticrénelage », était intégré juste devant le capteur d’image. Il servait principalement à supprimer les informations haute fréquence des images et à réduire les phénomènes de moiré et d’altération des couleurs causés par les ondes hautes fréquences. Le filtre passe-bas optique était généralement constitué de deux lames biréfringentes et d’une lame de longueur d’onde. En passant par ces lames biréfringentes, la lumière était fractionnée avant d’atteindre le capteur d’image. En outre, des traitements infrarouge et antireflet ainsi qu’un verre à absorption infrarouge permettait d’améliorer le rendu des couleurs.

L’augmentation de la résolution des capteurs numériques conduisant naturellement à la forte minoration de la taille du pixel réduit la fréquence des effets de moiré et des altérations de couleurs. Cela nous offre désormais la possibilité de supprimer le filtre passe-bas optique des appareils photo haute résolution pour profiter d’une bien meilleure netteté d’image. C’est ainsi que le FUJIFILM X100T dépourvu de filtre passe-bas permet très régulièrement d’obtenir des images clairement meilleures que mes anciens reflex NIKON dont le capteur était revêtu de ce type de filtre.

Le processeur : Le software complémentaire du numérique

Un appareil photo est devenu un véritable petit ordinateur, il s’agit simplement d’un microprocesseur de traitement du signal et de commande mais quelle puissance ! Un appareil photo n’est rien sans un processeur dédié au capteur numérique employé et aux éléments mécaniques éventuels corrélés car quand on en connaît son importance, on se rend vite compte qu’il peut s’avérer bien plus puissant que l’optique (sans un processeur d’image extrêmement puissant et rapide, de nombreux zooms aux amplitudes indécentes comme un 18-200mm ne pourraient prétendre à rien de plus que ce qu’ils sont réellement : de vrais culs de bouteille !). Ce processeur permet notamment globalement dans tous les appareils (reflex comme compacts) des prouesses qui étaient inimaginables en photographie argentique traditionnelle :

- La transformation Bayer

- Le dématriçage

- La réduction du bruit

- La netteté

- La correction gamma

- La détection de visage

- L’optimisation de la vitesse d’écriture et de travail (pour les rafales d’image par exemple)

- Des corrections optiques en temps réel (comme les déformations ou l’aberration chromatique)

- L’encodage JPEG

- Le redimensionnement

- Les rendus photographiques

- La gestion de la personnalisation de fonctions ou de boutons paramétrables de l’appareil

- La compression et encodage vidéo

- La gestion des éléments mécaniques corrélés avec l’électronique comme l’AF

Les sept grandes marques ont développé leur processeur dédié :

Marque | Processeur dédié | Descriptif |

|---|

CANON

|

DIGIC

|

Le processeur d’image DIGIC est dédié aux reflex CANON et le DIGIC DV aux camescopes. Comme NIKON, le DIGIC de CANON est à sa cinquième génération avec le DIGIC 5+. A chaque génération, un bruit numérique toujours plus faible, un AF toujours plus rapide et un flux de données toujours croissant dans le même délai de traitement.

|

|---|

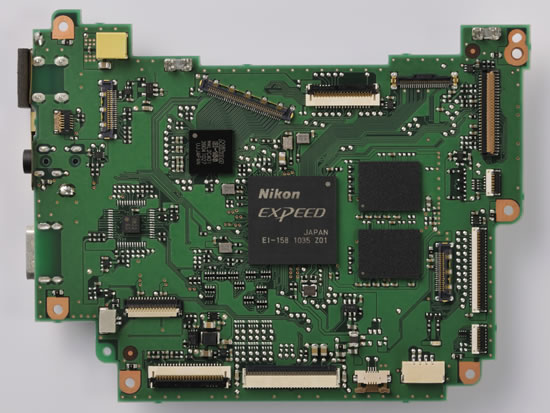

NIKON

|

EXPEED

|

NIKON est le plus bavard sur son processeur d’image et j’imagine que la structure soit assez semblable chez ses plus illustres concurrents.

Le EXPEED est un circuit intégré à application spécifique (ASIC) construit par Fujitsu spécialement pour Nikon pour respecter les spécifications de cette marque. Il s’agit d’une structure multi-processeur intégrée dans une puce, de sorte que chaque processeur puisse traiter parallèlement de nombreuses instructions pour une rapidité optimale, avec une gestion de réduction énergétique. Chaque processeur est capable de gérer 16 bits/pixel soit jusqu’à 28 instructions par cycle d’horloge et le noyau. On combinant toutes les unités composant le processeur d’image (processeurs, modules et interfaces), il peut traiter simultanément jusqu’à 112 opérations par cycle. A chaque nouvelle génération d’appareil photo reflex NIKON correspond une nouvelle génération de processeur d’image ; en janvier 2016, NIKON inaugurait l’EXPEED 5 pour son tout dernier vaisseau amiral, le NIKON D5.

|

|---|

PENTAX

|

PRIME

|

Depuis 2013, PENTAX est à sa troisième génération de processeur d’image avec le PRIME III intégré au PENTAX K-3 permettant la gestion de hautes résolutions supérieures à 20 millions de pixels.

|

|---|

SONY

|

BIONZ (X)

|

SONY est très peu communicatif sur son processeur d’image. On notera seulement deux générations : BIONZ (2006-2013) et BIONZ X depuis 2013. Le processeur d’image le plus abouti, le BIONZ X, inclu notamment un traitement du bruit optimisé en fonction de la région, selon s’il s’agit d’une zone sombre ou claire, sans compter une limitation particulièrement remarquable de l’effet de diffraction.

|

|---|

OLYMPUS

|

TRUE PIC

|

OLYMPUS est à sa sixième génération de processeur d’image en 2015 avec le TRUE PIC 6. On notera une amélioration du rendu couleur et traitement toujours plus rapide à chaque génération depuis 2004.

|

|---|

SIGMA

|

TRUE

|

Le capteur FOVEON de SIGMA est particulier dans sa conception et le processeur d’image TRUE permet bien justement d’en exploiter le potentiel grâce à une fonction de dématriçage atypique.

|

|---|

FUJI

|

FUJI EXR

|

En 2016, avec le nouveau capteur X-TRANS III de 24 millions de pixels installé dans le X-PRO 2, FUJI a inauguré une nouvelle génération de processeur d’image, bien plus véloce, capable de repousser les limites du possible jusqu’à l’intégration de « grain argentique » dès la prise de vue et une nouvelle simulation de film NB « ACROS ». Ainsi, l’EXR II que l’on trouve dans mon FUJI X100T a tiré définitivement sa révérence et laisse la place au nouveau processeur X Pro, censé selon Fujifilm assurer une meilleure gestion du bruit ainsi qu’une reproduction plus fidèle et des tons et des couleurs. Tout en soulignant une amélioration significative de la vitesse de traitement des données (comme la plupart des processeurs d’image des concurrents en somme !).

|

|---|